Datacenters : un défi énergétique qui s’intensifie

Derrière chacune de nos actions numériques se cache un datacenter qui nous permet d’effectuer des actions qui aujourd’hui semblent banales.

Derrière chacune de nos actions numériques se cache un datacenter qui nous permet d’effectuer des actions qui aujourd’hui semblent banales.

En France, selon le bilan énergétique RTE de 2023, plus de 300 datacenters sont répertoriés avec une consommation électrique estimée à près de 10 TWh et qui pourrait tripler à horizon 2030, soit 23 à 28 TWh. Ces chiffres sont d’autant plus probables que l’accélération récente de l’Intelligence Artificielle joue en faveur d’une forte augmentation des capacités des datacenters. D’après l’AIE (l’Agence Internationale de l’Énergie), une requête sur ChatGPT est dix fois plus consommatrice d’énergie qu’une recherche sur Google. La problématique est au final de voir comment limiter l’impact énergétique du développement de l’IA et du numérique de manière générale.

Un peu de vocabulaire

On fait parfois la confusion entre data center, terme générique et centre de calcul, terme plus spécifique : dans un centre de calcul, les serveurs sont destinés à effectuer des calculs complexes, alors que les datacenters couvrent un spectre d’usage très vaste : du stockage de données, des services cloud, de l’hébergement de site web ou d’autres services. La composition des serveurs diffère dans l’un et l’autre cas, avec pour les centres de calcul des composants très puissants pour générer une grande capacité de calcul et par conséquent une grande consommation électrique et la nécessité de disposer d’un système de refroidissement efficace. Il est pour le moment difficile de comparer en termes de consommation énergétique un centre de calcul à la moyenne des datacenters en France : pour donner un ordre de grandeur, les datacenters consomment en moyenne en France 5,15 MWh/m2/an.

Consommation énergétique d’un datacenter

Quels sont les différents postes de consommation énergétique d’un datacenter ?

Les deux principaux postes de consommation sont l’alimentation électrique des serveurs et leur refroidissement (nous reviendrons plus spécifiquement sur ce point).

La répartition exacte des consommations électriques d’un datacenter varie selon son « PUE ». Le Power Usage Effectiveness (PUE) est l’un des indicateurs les plus importants pour comparer les datacenters entre eux. Il se définit selon la formule suivante :

![]()

Il peut représenter 40% des consommations d’un datacenter si le PUE est élevé. Plus le PUE est proche de 1, plus le datacenter est performant.

Il peut représenter 40% des consommations d’un datacenter si le PUE est élevé. Plus le PUE est proche de 1, plus le datacenter est performant.

Le PUE joue un rôle majeur car il permet non seulement d’avoir une bonne image auprès des clients, mais il améliore également la rentabilité du datacenter en diminuant le poste de dépense le plus impactant pour un datacenter, à savoir l’achat de l’électricité.

Pour améliorer le PUE il existe plusieurs méthodes, mais celle-ci restent limitées par la technologie de refroidissement utilisée.

Technologie de refroidissement des serveurs

Les différentes technologies de refroidissement des serveurs influencent fortement le potentiel de récupération de la chaleur fatale ; c’est là un enjeu majeur, compte tenu du volume des gisements qu’elle représente. Sans entrer dans le détail de chaque solution existante, voici un aperçu des principales technologies couramment utilisées :

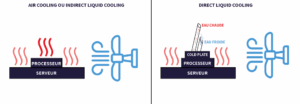

Le refroidissement par air (air cooling) utilise l’air comme unique vecteur de refroidissement, en projetant l’air via des ventilateurs sur les serveurs. Cette méthode atteint cependant ses limites sur des serveurs trop puissants, lorsque la densité thermique devient trop importante. L’air utilisé doit conserver une température assez basse pour être capable de refroidir les serveurs, ce qui peut être problématique lors des pics de chaleur notamment. L’air est généralement refroidi par des climatiseurs.

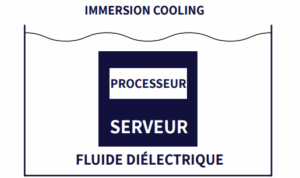

Le refroidissement par liquide sous plusieurs forme différentes (liquid cooling) :

Comme explicité précédemment, cette partie n’a pas pour objectif de dresser un panorama complet et détaillé de chaque solution, mais plutôt de donner une vision générale des principales technologies actuellement utilisées dans les datacenters.

Pour certains, le refroidissement par fluide via un échangeur est considéré comme du refroidissement indirect, tandis que le refroidissement par immersion est classé comme direct. Dans notre cas, cette distinction n’affecte pas l’objectif, qui reste de présenter les différentes approches existantes.

Il existe également d’autres méthodes de refroidissement tel que le refroidissement diphasique mais il n’est pas utilisé à grande échelle en raison de sa complexité pour le moment.

Valorisation de la chaleur fatale

En plus d’être de gros consommateurs d’électricité, les datacenters sont également une source significative de chaleur fatale. Bien qu’ils n’en aient pas besoin pour leur fonctionnement, cette chaleur peut parfois être réutilisée pour chauffer les locaux du site. Toutefois, cela ne suffit pas à valoriser l’ensemble du potentiel thermique disponible. Une solution plus pertinente consisterait à injecter cette chaleur dans un réseau de chauffage urbain, bien que peu de datacenters y soient actuellement connectés — une situation susceptible d’évoluer dans les prochaines années. Le potentiel de valorisation de la chaleur résiduelle est étroitement lié au type de système de refroidissement utilisé.

Dans les systèmes de refroidissement par air, l’air extrait n’atteint généralement pas une température suffisante pour être valorisé efficacement. Pour le refroidissement indirect, il est plus facile de récupérer la chaleur que le refroidissement par air en venant directement récupérer les calories sur le groupe froid qui refroidit le fluide. Cependant, lorsque la demande de chaleur est importante en hiver, le groupe froid ne fonctionne pas à plein régime : on privilégie alors le free chilling, c’est-à-dire le refroidissement de l’eau via l’air extérieur à l’aide d’un échangeur, plutôt que l’utilisation du groupe froid. À l’inverse, en été, lorsque la demande de chaleur est faible, le groupe froid fonctionne à pleine capacité. La récupération de chaleur dans ce type de configuration n’est donc pas en adéquation avec les besoins.

Le refroidissement direct, permet de récupérer la chaleur via une boucle d’eau chaude de manière plus efficiente. Néanmoins, la température de cette eau ne dépasse généralement pas 50°C, ce qui reste insuffisant pour une valorisation directe. L’utilisation d’une pompe à chaleur permettrait d’augmenter cette température, mais le delta thermique étant important, le modèle économique reste difficilement rentable dans le contexte actuel des prix de l’énergie.

Le refroidissement par immersion pourrait cependant changer la donne. En plus d’améliorer l’efficacité énergétique des serveurs en permettant des PUE plus faibles, il pourrait permettre d’atteindre des températures de sortie plus élevées, jusqu’aux alentours de 60 à 65°C. Cela rend la chaleur récupérable beaucoup plus compatible avec les réseaux de chaleur, rendant son exploitation économiquement plus intéressante.

De plus, contrairement à de nombreuses activités industrielles, un datacenter peut facilement être intégré en zone urbaine, facilitant ainsi son raccordement aux réseaux de chaleur. C’est notamment le cas du datacenter de Totalinux, dans les Yvelines, conçu pour alimenter en chaleur un réseau urbain connecté au bâtiment.

Peu de datacenter utilisent le refroidissement par immersion, ce qui explique qu’aujourd’hui il y a peu de datacenters reliés à des réseaux de chaleur. Chaque système a ses avantages et inconvénients que nous n’avons pas détaillés, mais l’objectif était de dresser le panorama des solutions de refroidissement actuelles et de comprendre les freins techniques ou économiques à la valorisation de la chaleur fatale.

Pour limiter l’impact énergétique des datacenters, dont la croissance est forte, il est essentiel de concevoir des infrastructures dotées de systèmes de refroidissement à haute performance. La France a d’ailleurs affirmé ses ambitions en la matière lors du sommet de l’IA à Paris en février, en identifiant 35 sites « prêts à l’emploi » pour accueillir de futurs datacenters. Ces installations devront être pensées dans leur globalité, en intégrant à la fois l’optimisation du refroidissement des serveurs et la valorisation de la chaleur fatale à proximité des sites.

Développement des data centers

D’après RTE, en septembre 2024, 4,5 GW de demandes de raccordement ont déjà été signées pour des datacenters en France et il reste un volume équivalent en instruction. En comparaison, fin 2023, le parc français de production d’électricité représente 148 GW.

La France possède une électricité décarbonée en grande quantité, ce qui en fait un territoire très intéressant pour le développement de datacenters. La vraie difficulté réside dans le raccordement de ces infrastructures : leur nombre tout d’abord et les travaux de raccordement que cela suscitera, mais également les réelles chances d’aboutissement des projets et les puissances souvent surestimées par rapport au besoin réel. Ces demandes sont à comptabiliser avec l’électrification des usages en lien avec la décarbonation de l’industrie, la multiplication des infrastructures de recharges pour voitures électriques et les projets d’électrolyses de l’hydrogène.

À partir du 1er août, RTE pourra, sous certaines conditions, diminuer la puissance de raccordement si celle-ci n’est pas pleinement utilisée afin d’éviter d’avoir, comme aujourd’hui une capacité électrique disponible mais non utilisée. Cela permettra d’utiliser pleinement notre réseau actuel et de faciliter le raccordement de nouvelles installations.

C’est ce contexte qui complexifie pour l’heure le développement des datacenters en France malgré la disponibilité de l’électricité. D’où la volonté de l’État de préqualifier des sites « prêts à l’emploi » avec un raccordement électrique échelonné selon différents horizons temporels.